现在,代码完成模型领域又出现了一股“新生力量”。

近日,开放了稳定扩散源头的Stable发布了新的大模型——Stable code,这是其首个用于编码的生成式AI大模型。Stable将其描述为“革命性的”。

据介绍,StableCode旨在帮助程序员处理日常工作,同时为开发新手提供了一个很好的学习工具,让他们通过上一层楼梯来掌握技能。

官方博客地址:https://stability . ai/blog/stable code-LLM-generative-ai-coding。

对于StableCode,网友期望很高,表示确实需要将整个代码库作为上下文的大代码模型。

三个版本:基本、指令和长上下文窗口模型。

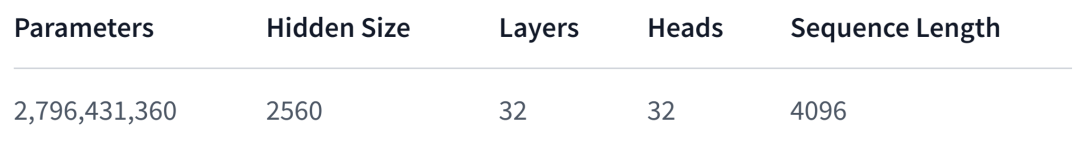

StableCode通过三个不同版本的模型帮助开发者变得更加高效。基本模型是“稳定码-补全-alpha-3b-4k”,这是一个仅使用解码器的30亿参数码补全模型。

基础模型已经在BigCode stack数据集的各种编程语言上进行了预训练,在Python、Go、Java、Javascript、C、markdown、C++等流行编程语言上进行了针对性的训练。总体而言,StableCode在HPC集群上训练了5600亿个令牌码。

BigCode here是2022年9月由HuggingFace和ServiceNow Research联合发起的大代码模型项目,旨在围绕AI代码生成工具建立开放社区,开发大语言模型代码。

hugging face:https://hugging face . co/stability ai/stable code-completion-alpha-3 b-4k

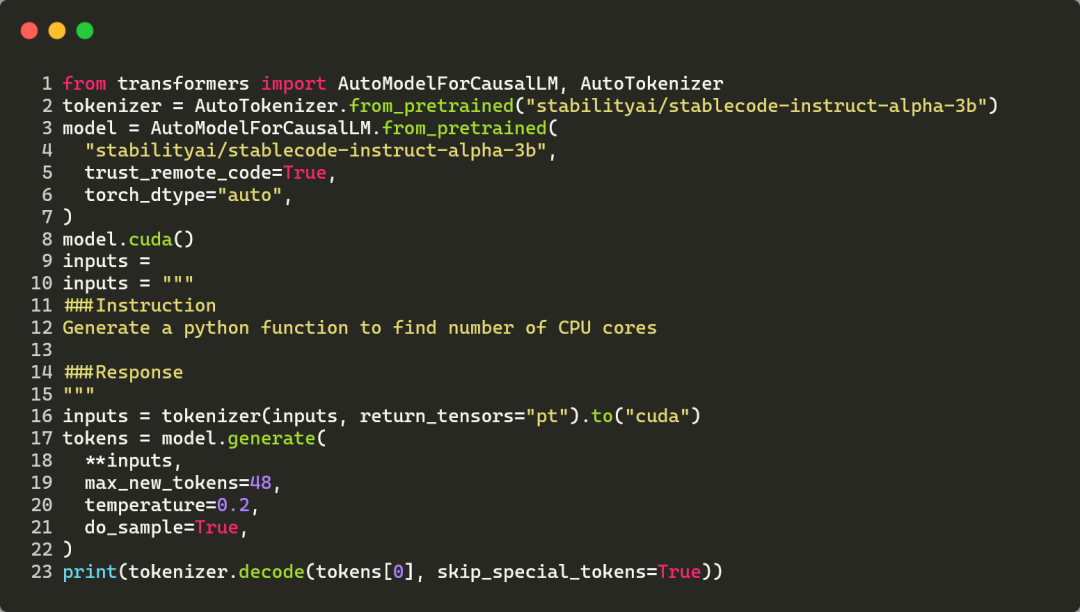

在基本模型的基础上,针对具体用例调整的指令模型“稳定代码-指令-alpha-3b”有助于解决复杂的编程任务。该模型也是一个仅使用解码器的30亿参数指令调整代码模型,并已在stackoverflow开发者调查报告中对顶级编程语言进行了预训练。

同时,在基本模型上训练了大约12万个羊驼格式的代码指令-响应对。下图显示了使用StableCode指令模型为给定指令生成响应的代码示例。

Huggingface地址:https://hugging face . co/stabilizai/stable code-instruct-alpha-3b。

对于那些想要学习更多编码技能的人来说,StableCode是一个理想的构建块。长上下文窗口模型“StableCode-Completion-Alpha-3B”堪称完美助手,保证用户可以使用单行和多行自动代码完成建议。

这个模型也是一个仅使用解码器的30亿参数代码完成模型,它在2023年stackoverflow开发者调查报告中使用最多的编程语言上进行了预训练。

与之前发布的开源模型相比,该模型的上下文窗口达到16000 token(比其他任何模型都大),一次可以处理更多的代码,是之前模型的2-4倍。这允许用户查看或编辑五个中等大小的Python文件,使其成为新手的理想学习工具。

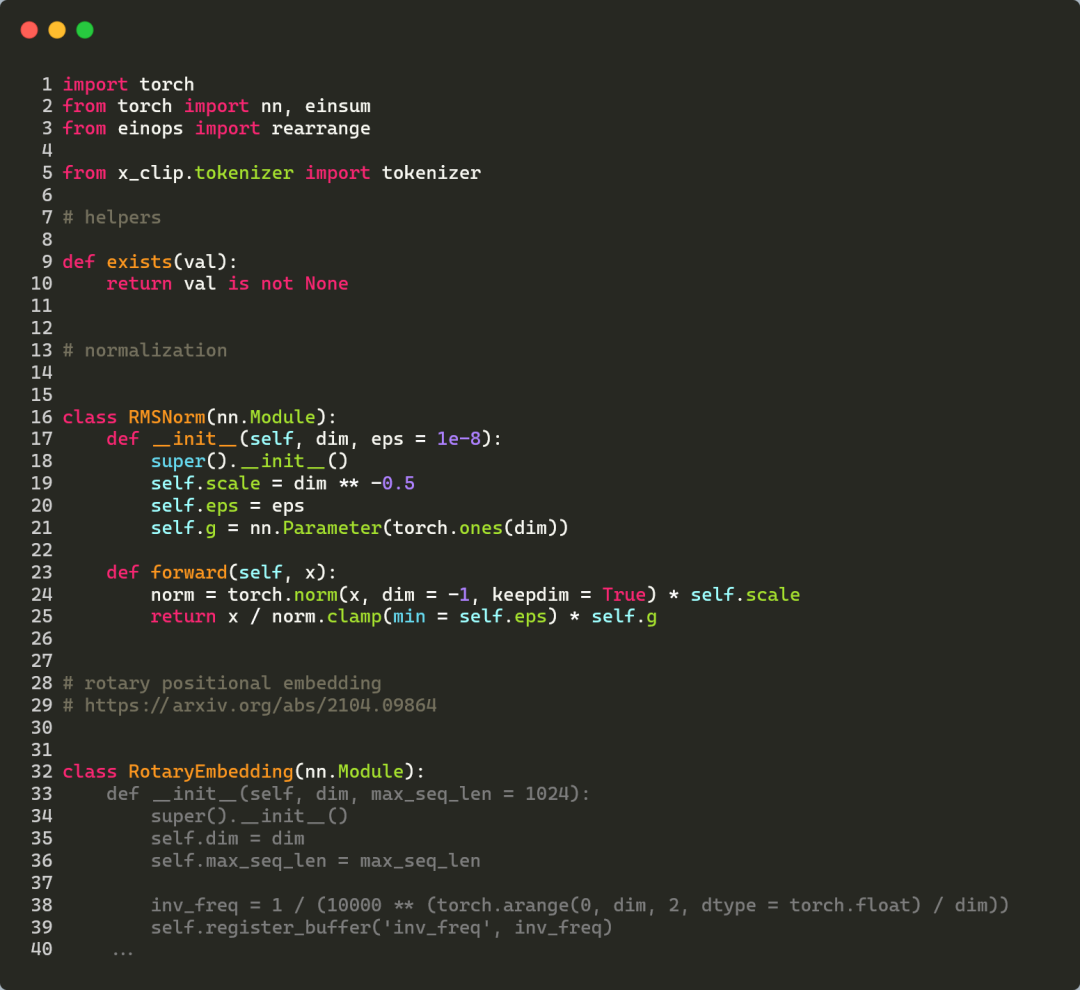

如下图所示,StableCode利用Pytorch深度学习库完成了一个复杂的Python文件,其中格雷码是StableCode的预测结果。

拥抱脸地址:https://hugingface.co/stabilizai/stable代码-完成-阿尔法-3b。

同级别模型对比结果

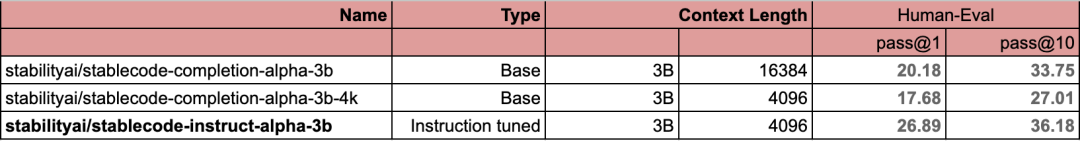

下表显示了StableCode模型的三个版本的基准分数。

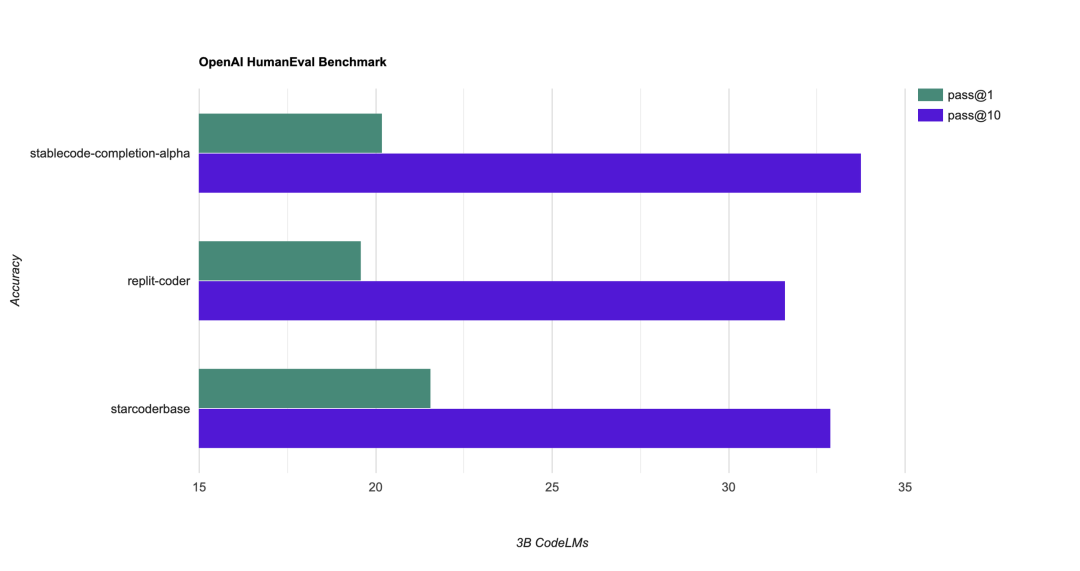

StableCode还与参数数量和token数量相近的同级别模型(30亿个参数)进行了对比,其中pass@1和pass@10指标在流行的HumanEval基准上使用。

从下图可以看出,对比replit-coder(引入AI编程独角兽replit)和starcoderbase,StableCode的pass@1强于Replit-Coder,弱于starcoderbase,强于pass@10。

原文链接:https://stability . ai/blog/stable code-LLM-generative-ai-coding。

剧终

授权请联系本微信官方账号。

投稿或寻求报道:content@jiqizhixin.com。

微信扫码

微信扫码

QQ扫码

QQ扫码

您的IP:10.8.251.137,2025-12-17 17:43:28,Processed in 0.18536 second(s).